資料探勘、機器學習、深度學習分不清楚?

資料探勘

機器學習

- K-means

- GAN (生成對抗網絡)

- TTS

- 電腦視覺

- 手寫辨識

- Support Vector Machine

(圖源:wiki)

(圖源:wiki)- 屬於非監督學習。

- 適用於無label的資料。

- 逐漸找出資料的中心點,來得知資料的特徵相似度。

- 找到Elbow point可知道該分類的組數(k)以減少迭代次數。

(圖源)

(圖源)

ref

ref ref:wiki

ref:wiki- 屬於監督式學習。

- 基於統計模型。

- 目標在找到能畫分資料的hyperplane(超平面,在n維空間找到n-1維平面),且能使Margin最大化。

範例:自動摘要生成AI

圖源[7]

圖源[7]- 語意相似度:例如King 跟Queen的概念相近。

- 屬型:例如King有個屬性為man。

- 依照統計法:執行較快。

- 依照語言學:效果可能較好。

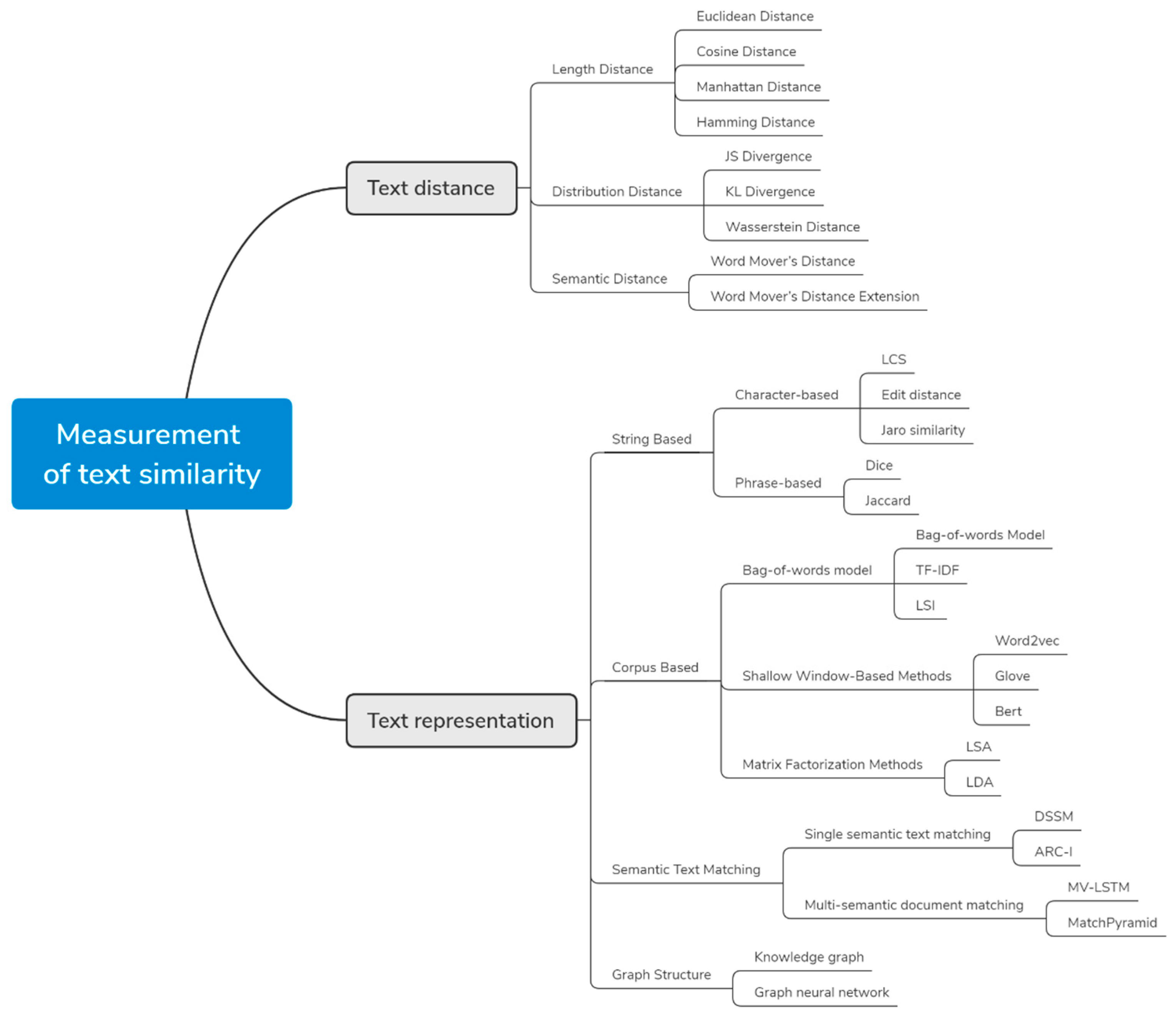

- Text Distance:語意上的評估。

- 長度距離

- 歐拉距離

- 餘弦距離

- 曼哈頓距離

- 漢明距離

- 分布距離:好處有(1.)適用於對稱問題,例如Sim(A,B) =Sim(B,A) [7];(2)只用距離計算相似度是不夠的[9]。

- JS Divergence:計算兩分布的相似度,常用於比對某主題與現有主題的相似度。

- KL Divergence

- Wasserstein Distance

- 語意距離:若句子無共用單字,導致距離相似度小,可考慮計算語意相似度。

- word mover’s distance:計算A移動(transform)到B的最小距離。

- 長度距離

- Text Representation:有的相似度計算會使用Knowledge based分類法,例如利用Wikipedia,則不用計算相似度距離。

- string based

- character-based

- Corpus based

- ....

Bag-Of-Word

LSA (Latent Semantic Analysis)

Wiki: SVD

Wiki: SVDCorpus based (語料庫)

Glove & Word2Vec是什麼?

- LSA(Latent Semantic Analysis)可以基於co-occurance matrix構建詞向量,實質上是基於全域語料採用SVD進行矩陣分解,然而SVD計算複雜度高

- Glove沒有直接利用共現矩陣,而是通過ratio的特性,將詞向量和ratio聯繫起來,建立損失函數,採用Adagrad對最小平方損失進行優化(可看作是對LSA一種優化的高效矩陣分解演算法)

題外話:BERT

- LSA:以統計方式求出該句子中的單詞的共現因子。

- TFSF:該論文自創,類似於TF-IDF的概念,差別在於用句子間的詞頻,而非文本間的詞頻。

- n-gram:由於該論文處理的是中文,使用n-gram找出最有可能的斷句。

- Jaccard:求LSA矩陣中各句子間的關聯性。

- 模糊理論:讓句子間能有關係的推導。

後記:

之後可能參考[8]的做法,改良專題作品。 最近在拚研究所推甄的資料,專題大概來不及實做完。 好多東西要捨取,好怕。文獻*因為這篇是網路文章,所以文獻也找得比較鬆散、多半來自網路的。 實際的正式論文已經看了40多篇,快吐了o( ̄┰ ̄*)ゞ

好多東西要捨取,好怕。文獻*因為這篇是網路文章,所以文獻也找得比較鬆散、多半來自網路的。 實際的正式論文已經看了40多篇,快吐了o( ̄┰ ̄*)ゞ

- Difference in Data Mining Vs Machine Learning Vs Artificial Intelligence (softwaretestinghelp.com)

- Deep Learning vs. Machine Learning – What’s The Difference? (levity.ai)

- 無監督學習 - 維基百科,自由的百科全書 (wikipedia.org)

- 監督學習 - 維基百科,自由的百科全書 (wikipedia.org)

- 【機器學習2021】預測本頻道觀看人數 (上) - 機器學習基本概念簡介 - YouTube 李宏毅老師系列課程

- (2) Can any one tell me what is the difference between k-means classification and svm classification? - Quora

- Wang J, Dong Y. Measurement of Text Similarity: A Survey. Information. 2020; 11(9):421. https://doi.org/10.3390/info11090421

- 周智勳, & 丁泓丞. (7 C.E., May 20). 增強型潛在語意分析基礎之文件自動摘要. Http://Chur.Chu.Edu.Tw/Bitstream/987654321/42894/1/098CHPI5392027-001.Pdf. http://chur.chu.edu.tw/handle/987654321/42894

- Deza, M. M., & Deza, E. (2009). Encyclopedia of distances. In Encyclopedia of distances (pp. 1-583). Springer, Berlin, Heidelberg.

- Croft, D., Coupland, S., Shell, J., & Brown, S. (2013, September). A fast and efficient semantic short text similarity metric. In 2013 13th UK workshop on computational intelligence (UKCI) (pp. 221-227). IEEE.

- 語料庫語言學 - 維基百科,自由的百科全書 (wikipedia.org)

- 斯坦福大学的词向量工具:GloVe – 标点符 (biaodianfu.com)

- (十五)通俗易懂理解——Glove演算法原理 - 知乎 (zhihu.com)

- Continuous Bag of Words (CBOW) - Single Word Model - How It Works - ThinkInfi

- Skip-Gram: NLP context words prediction algorithm | by Sanket Doshi | Towards Data Science

- 史上最全詞向量講解(LSA/word2vec/Glove/FastText/ELMo/BERT) - 知乎 (zhihu.com)

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., ... & Polosukhin, I. (2017). Attention is all you need. Advances in neural information processing systems, 30.